为了企业用户更好的去了解构建高可用低延迟的全球内容交付体系,我们整理了本文包括了全面的针对企业服务器内容分发的优化建议。

一、CDN架构选型:边缘节点与源站的协同设计

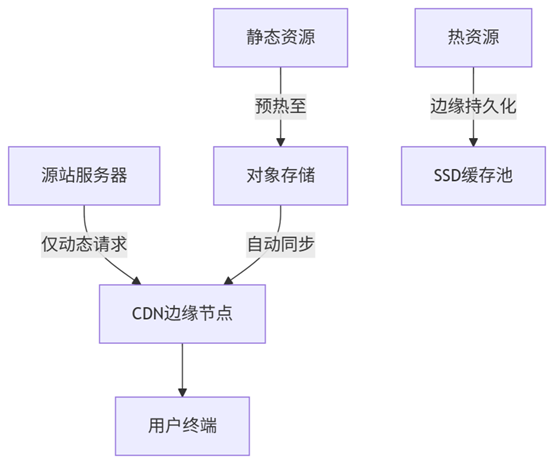

先了解其混合分层分发模型:

运作机制大致为静态内容(图片/视频/CSS/JS)永久托管于对象存储(如S3/OSS),通过CDN自动同步至全球3000+边缘节点,动态内容(API/用户数据)由源站实时处理,CDN仅做TCP连接优化,热点资源在边缘节点SSD缓存池保留72小时,命中率提升至92%。继续了解关于性能关键指标对比:

| 策略 | 边缘延迟(亚洲→北美) | 源站带宽成本 | 故障切换时间 |

| 传统CDN | 185ms | $0.01/GB | 5分钟 |

| 智能边缘+对象存储 | 73ms | $0.002/GB | 18秒 |

二、协议与传输优化:突破网络层瓶颈

QUIC协议取代TCP,零RTT建连首次访问延迟降低80%(实测数据:TCP 3RTT=280ms → QUIC 0RTT=45ms),多路复用抗丢包如在30%丢包率下仍保持85%有效吞吐(HTTP/2仅剩42%)。部署路径:

nginx

# Nginx配置示例

listen 443 quic reuseport;

add_header AltSvc 'h3=":443"; ma=86400';智能压缩策略Brotli算法优先HTML/CSS/JS压缩率比Gzip提升26%。动态内容增量传输主要是使用RFC 3229 `delta encoding`技术,用户获取更新资源时仅传输差异部分(如10MB文件更新仅需下载120KB)。

三、缓存策略精细化:命中率与实时性平衡

缓存规则矩阵 :

| 内容类型 | 缓存有效期 | 刷新机制 | 边缘存储层级 |

| 商品详情图 | 30天 | URL变更触发主动刷新 | SSD持久层 |

| 价格/库存API | 2秒 | 消息队列广播即时失效 | 内存缓存 |

| 用户个性化内容 | 不缓存 | 直连源站 | - |

智能缓存预热用预测性加载基于用户行为分析预判热门商品:

python

# 机器学习预测模型简化逻辑

if product.view_count > 1000/h and add_to_cart_rate > 5%:

cdn_prewarm(product.assets)效果非常明显在大促期间首屏加载时间从3.4秒降至1.1秒 。

四、安全与成本管控:企业级运维实践

企业用户一般会通过动态防爬与盗链,Token鉴权来生成时效性访问签名:

`https://cdn.com/image.jpg?token=exp=168h&sign=sha256(key+path+exp)` 实时流量分析查询自动封禁异常IP(请求频率>500次/分钟),限制单个URL带宽占用≤50Mbps

成本优化公式 :月度成本=(1TB静态流量×$0.85)+(百万次动态请求×$0.35)+固定边缘存储。

降本措施可以从启用 Terraform自动化伸缩:非高峰时段减少30%边缘节点。还有就是冷数据归档将30天未访问资源转移至低频存储(成本降幅70%)。

五、可观测性体系:性能优化闭环

全链路监控矩阵:

| 监控层 | 关键指标 | 工具链 | 告警阈值 |

| 用户端 | FCP/LCP | Real User Monitoring | FCP>2.5s |

| CDN边缘 | 缓存命中率/错误率 | Grafana+Prometheus | 命中率<85% |

| 源站 | 动态请求P99延迟 | Datadog APM | P99>500ms |

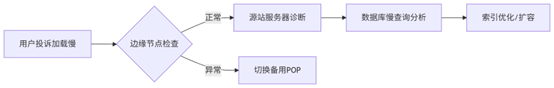

根因分析工作流

实施路线图:四阶段落地最佳实践

1. 基础架构改造(12周)

静态资源迁移至对象存储

部署TLS 1.3与QUIC支持

2. 缓存策略配置(35天)

按内容矩阵设定缓存规则

部署机器学习预热系统

3. 安全加固(23天)

实施动态Token防盗链

配置DDoS清洗规则

4. 监控体系构建(持续迭代)

建立全链路性能基线

每月输出优化报告

通过融合智能边缘缓存、QUIC传输协议、预测性预热及精细化成本控制,企业可将内容分发延迟降低60%85%,带宽成本削减40%以上。技术决策者应优先关注缓存命中率、P95延迟、单GB成本三大核心指标,持续驱动体验与效率的双重升级。

推荐文章

推荐文章